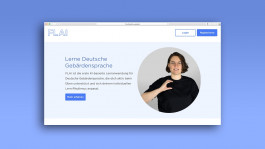

FLAI

Finger Language Artificial Intelligence

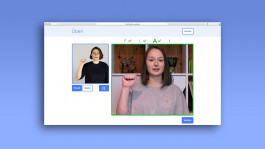

FLAI ist eine Full-Stack-Webanwendung, die Grundlagen der Deutschen Gebärdensprache (DGS) vermittelt. Ihr Kernstück: die Feedbackfunktion, die in Echtzeit erkennt, ob der*die User*in richtig gebärdet – oder noch ein wenig üben sollte. Alles, was Nutzer*innen dafür brauchen, ist eine Webcam. Den Rest übernimmt ein Ensemble neuronaler Netze, in dem das FLAI-eigene Netz die erste Geige spielt.

Vom Entwurf des neuronalen Netzes bis zur Wahl der Typografie: Barriere- und Diskriminierungsfreiheit sind die Grundgedanken, die die Entstehung des Prototyps von Anfang an bestimmen. Denn für einen respektvollen Umgang mit Gebärdensprache als zentralem Bestandteil der Gehörlosenkultur, war es dem Entwickler*innen-Team wichtig, Einstiegshürden so niedrig wie möglich zu halten.

Lernmodell

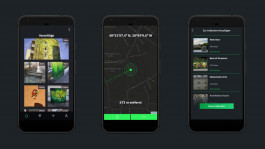

Eine neue Sprache ist oft mit einer Hemmschwelle verbunden. Das Live-Feedback fordert dazu auf, diese Hemmschwelle zu überwinden. Durch visuelle Rückmeldung unterstützt FLAI Anfänger*innen dabei, sich Gebärden von Anfang an richtig anzueignen und sie selbstbewusst anzuwenden.

Darüber hinaus ermöglicht es die Feedbackfunktion, Buchstabierübungen nach dem „Karteikasten-Prinzip“ aufzubauen: Buchstaben, die der*die Nutzer*in gut beherrscht, werden seltener abgefragt als die mit größerem Übungsbedarf. So passen sich die Aufgaben an seinen*ihren individuellen Lernfortschritt an.

Design

Die große Design-Herausforderung bestand darin, Ästhetik und Barrierefreiheit zusammenzubringen. Dabei lag der Fokus darauf, ein Farbschema zu finden, mit dem alle gestalterischen Elemente für Menschen mit Farbfehlsichtigkeiten optimiert werden können.

Mit Gotham ScreenSmart wurde eine speziell für die Lesbarkeit am Bildschirm entwickelte Typografie gewählt.

Das Layout der Webseite ist bewusst reduziert, um nicht von den wesentlichen Features abzulenken.

Technik

Ein wichtiges Ziel bei der Entwicklung war es, möglichst vielen Menschen uneingeschränkten Zugang zu FLAI zu verschaffen. So macht die Kombination aus Vorverarbeitung des Kamerabilds und Gebärdenerkennung durch das FLAI-eigene neuronale Netz das Live-Feedback robust gegenüber Umwelteinflüssen wie Hintergrund oder Lichtverhältnissen.

Das beschränkt sich nicht nur auf die Nutzung: auch interessierte Entwickler*innen sollen das Projekt einsehen und weiterentwickeln können. Deshalb sind Datensatz und Quellcode Open Source verfügbar.

Team

Stefanie Jany, Lea Jell, Martin Kohnle, Anja Krendlinger, Moritz Kronberger, Eva Kunzmann, Kieu Pham

Betreuer

Wolfgang Kowarschick und Oliver Luxenhofer

Links

Quellcode: GitHub

Datensatz: Kaggle

Anwendung (Nur im Hochschulnetz oder per VPN zugänglich):

https://flai.multimedia.hs-augsburg.de